ChatGPT-4: Comprendre pour mieux anticiper

Depuis quelques semaines, un sujet brûlant retient l’attention de Paris à Washington en passant par Abidjan ou Mumbai : la sortie de ChatGPT-4 (GPT pour Generative Pre-Trained Transformer), la version la plus avancée du Chatbot d’OpenAI utilisant un modèle d’intelligence artificielle appelé «LLM» (Large Language Model), développé par la société OPEN AI, dont Microsoft est l’actionnaire majoritaire.

En une nuit, OPEN AI est passée d’une startup à une licorne valorisée à plus de 29 milliards de dollars, ce qui a rapidement fait prendre conscience au monde des multiples implications de cette technologie dans notre vie quotidienne. En réalité, celles-ci seront encore plus profondes, car les modèles LLM ne se limitent pas aux GPT, mais peuvent être utilisés dans le codage, la prédiction de séquences protéiques, la santé, les jeux d’échecs, le recrutement, l’art, la finance et bien d’autres domaines.

Et ce n’est que le début, car la précision, les capacités, la vitesse et le développement de technologies complémentaires à cette forme d’intelligence artificielle connaissent une croissance exponentielle. Par conséquent, il y a une forte probabilité que des secteurs entiers soient bouleversés par cette innovation radicale. Cependant, l’excitation générale entourant l’adoption de ces technologies liées à l’intelligence artificielle s’accompagne également de nombreuses questions et inquiétudes sur les contraintes éthiques inhérentes à leur utilisation à grande échelle ainsi que sur les erreurs graves qui pourraient en résulter.

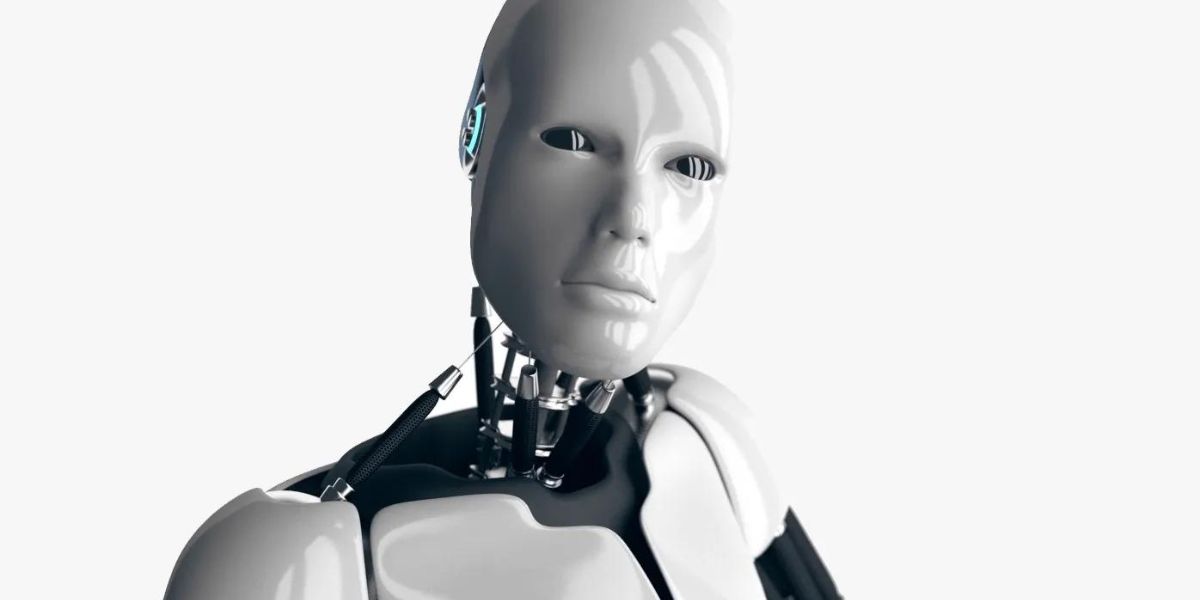

Il est légitime de se demander comment garantir l’authenticité des informations que nous recevons et qui influencent nos choix. Jusqu’à récemment, la plupart d’entre nous auraient trouvé amusant de faire un parallèle entre la réalité et le célèbre film de science-fiction «Terminator» de James Cameron, sorti en 1984.

Cependant, il est maintenant temps de réfléchir sérieusement à la situation. Serons-nous en mesure de contrôler l’équité des analyses basées sur les prédictions de ces systèmes, afin qu’elles ne soient pas injustement défavorables envers certaines minorités ? Comment vérifier que les décisions prises par une technologie intégrant l’intelligence artificielle ne soient pas biaisées, sachant qu’elles pourraient avoir un impact sur des milliards de vies ? Serons-nous capables de contrôler et de nous discipliner dans l’utilisation de l’IA ?Bien qu’il faille s’adapter rapidement à ces changements radicaux afin de tirer profit des immenses opportunités qui voient le jour, il est légitime et nécessaire de se poser ces questions afin d’anticiper les problématiques qui pourraient en découler d’un point de vue éthique. L’éthique se concentre sur l’étude de la morale et du comportement humain, fournissant un cadre et des normes de conduite qui orientent nos décisions, tant sur le plan personnel que professionnel.

Dans le contexte de l’intelligence artificielle, l’application de normes éthiques peut aider les développeurs et les utilisateurs à définir les limites des décisions pouvant être prises à partir des recommandations fournies par les systèmes embarquant ces technologies. Les questions éthiques liées à l’IA sont nombreuses d’autant plus que celles-ci prennent des décisions de manière autonome.

Biais potentiels des données et de la prise de décision dans les systèmes intégrant l’IA

Les biais potentiels des données et des prises de décision dans les systèmes intégrant l’intelligence artificielle constituent l’une des principales causes de problèmes éthiques et sociétaux, se distinguant des autres technologies d’automatisation.

Ces biais font référence aux potentielles erreurs systématiques dans les données qui sont utilisées pour entrainer l’intelligence artificielle. Lorsque ces systèmes prennent des décisions (ou plutôt fournissent des recommandations), ces décisions peuvent être biaisées et injustement défavorables envers certains groupes ou individus.

Bien que les problèmes de biais et de discrimination aient toujours existé dans la société moderne, il est préoccupant de constater que l’IA peut perpétuer ces biais et étendre leur impact de manière infinie. Les trois principales sources de biais sont liées à la taille ou à la qualité de l’échantillonnage des données, aux préjugés humains qui peuvent altérer les données voire l’algorithme, ainsi qu’aux limitations techniques qui peuvent affecter la performance de l’IA.

Le biais de sélection survient lorsque l’échantillonnage utilisé pour entraîner l’intelligence artificielle n’est pas représentatif de la population réelle ou de l’ensemble des données disponibles. Ce type de biais peut entraîner ou renforcer une asymétrie dans les prédictions, qui ne représente pas nécessairement toute la population.

En effet, la précision de l’algorithme d’apprentissage dépend de l’échantillon de données utilisé pour le nourrir dès le départ. Un exemple bien connu et largement documenté dans la littérature est celui du chatbot Tay, lancé par Microsoft en 2016 (L. Dixon, J. Li, J. Sorensen, N. Thain, 2018). Les développeurs l’ont rapidement déconnecté après qu’il ait tenu des propos racistes, misogynes et vulgaires. Comment cela s’est-il produit ? Tay se nourrissait tout simplement des conversations qu’il avait avec les utilisateurs de Twitter, ce qui l’a irrémédiablement biaisé. Un autre type de biais se manifeste lorsque les personnes chargées de collecter les données ou de développer l’algorithme ont des préjugés, ce qui peut favoriser ou défavoriser certaines parties de la population.

Un exemple de biais de préjugé est l’utilisation des données historiques sur les incarcérations aux États-Unis, qui pourrait conduire une intelligence artificielle utilisée dans le système judiciaire à prendre des décisions défavorables à la population afro-américaine. Un autre exemple de ce type de biais a été analysé par des chercheurs du MIT qui ont découvert un biais de préjugé sur certaines technologies de reconnaissances faciales intégrant l’IA et qui avaient des taux d’erreur disproportionnés en fonction de la couleur de peau et du genre (Buolamwini, J., &Gebru, T., 2018). Les systèmes testés avaient une précision plus faible pour les femmes à la peau foncée, tandis qu’ils étaient plus précis pour les hommes à la peau claire.

Ce qui démontrait un biais préjudiciable pouvant entraîner des conséquences discriminatoires dans des domaines tels que la sécurité, les systèmes de surveillance ou même les décisions d’embauche. Enfin, le biais de mesure en intelligence artificielle fait référence à un écart ou à une distorsion dans les mesures utilisées pour évaluer les performances d’un modèle ou d’un système d’intelligence artificielle. Ces biais peuvent être introduits lorsque des métriques inappropriées sont choisies ou lorsque les méthodes d’évaluation ne capturent pas de manière exhaustive les caractéristiques essentielles du problème à résoudre.

Ces types de biais peuvent entraîner une évaluation erronée des performances des modèles intégrant l’IA, ce qui peut conduire à des prédictions incorrectes et introduire des distorsions dans les comparaisons entre différents modèles. Un exemple concret de biais de mesure pourrait se produire dans un système de recommandations de films. Si l’on mesure la précision du modèle en fonction de la correspondance entre les recommandations et les évaluations des utilisateurs, cela peut potentiellement introduire un biais.

En effet, les utilisateurs ont souvent tendance à noter positivement les films recommandés, influencés par le simple fait qu’ils leur ont été suggérés, plutôt que par leur réelle satisfaction. Cela peut entraîner une surestimation des performances du système de recommandation lui-même (Ekstrand et collab., 2018).

En résumé, les décisions prises en utilisant des systèmes prédictifs basés sur l’intelligence artificielle, de manière implicite, ont le potentiel non seulement d’amplifier les biais déjà présents, mais aussi d’en générer de nouveaux qui peuvent avoir un impact sur l’équité et l’exactitude de ces décisions (voir Figure 1).

Ces systèmes ne sont donc pas infaillibles. Ils s’appuient sur l’apprentissage du passé pour anticiper l’avenir et la figure 1 montre à quel point chacun des trois biais peut potentiellement amplifier le suivant dans une boucle infinie conduisant à des erreurs qui, si elles ne sont pas détectées en amont, entraîneront des conséquences néfastes pour l’ensemble des parties prenantes.

Transparence et confidentialité des données

Dans ses directives éthiques sur le développement de l’intelligence artificielle, le comité d’experts de haut niveau de l’Union européenne a souligné l’importance cruciale de la transparence et de la confidentialité des données pour construire une «intelligence artificielle digne de confiance».

En réalité, la transparence des données est un élément central dans un nombre croissant de recherches portant sur le cadre éthique de l’intelligence artificielle (Jobin et collab., 2019). Cette notion de transparence se révèle être le fil conducteur dans les travaux visant à établir les fondements éthiques de l’intelligence artificielle.

Mais que signifie la transparence des données dans le contexte de l’intelligence artificielle ?

Dans la littérature académique, la transparence est souvent associée à l’interprétabilité et à la confiance des systèmes (Ribeiro, Singh, & Guestrin, 2016). Pour atteindre cet objectif, de nombreux domaines connexes doivent être pris en compte (Larson, 2009).

Par exemple, il est nécessaire de délimiter les aspects juridiques de la propriété afin de protéger à la fois les sources d’information et les utilisateurs. Lorsque vous posez une question à ChatGPT, comment peut-on s’assurer que les sources utilisées par l’algorithme ne sont pas la propriété d’un tiers ?

Qui sera responsable de leur utilisation ? Ne peut-on pas déceler une certaine forme d’opacité intentionnelle quelque part (de Laat, 2018) ? Ces questions soulignent ainsi l’importance de clarifier les mécanismes de propriété et de responsabilité pour garantir la transparence et la confiance dans l’utilisation de l’intelligence artificielle. La question de l’interprétabilité et de la transparence des données, ainsi que du fonctionnement des algorithmes, qui est déjà cruciale dans le contexte des algorithmes déterministes, devient encore plus critique lorsqu’il s’agit d’intelligence artificielle et de systèmes d’apprentissage.

En effet, le principe fondamental de ces systèmes est précisément de parvenir à une forme d’autodétermination en développant leurs propres cadres pour prendre des décisions de manière autonome.

Cependant, dans ce cas, comment peut-on s’assurer que la méthodologie et le fonctionnement de ces systèmes restent explicables ? Sans cette explication, le principe même de transparence des données serait remis en question.

Il est donc essentiel de trouver des moyens d’assurer une compréhension claire et transparente des processus de prise de décision de l’intelligence artificielle, afin de préserver la confiance des utilisateurs et de garantir une utilisation éthique de ces systèmes.

L’intelligence artificielle et les dangers de l’automatisation des prises de décision

Un autre phénomène découlant de ces concepts est la prise de décision automatisée associée à ces algorithmes prédictifs, qui pourrait entraîner des conséquences éthiquement douteuses.

Comment peut-on s’assurer que les prédictions qui pourraient influencer des milliards de vies restent limitées à une aide à la décision qui sera analysée et utilisée par un être humain plutôt qu’automatisée ?

En effet, par nature, un algorithme est censé être objectif, et avec l’évolution exponentielle de la précision des LLM et d’autres machines d’apprentissage, il deviendra de plus en plus difficile de remettre en question ces prédictions.

Néanmoins, le droit individuel de ne pas être soumis à la décision d’une machine peut raisonnablement être soulevé. De même, les personnes qui prendront des décisions allant à l’encontre des prédictions de l’intelligence artificielle seront-elles tenues responsables des conséquences en cas d’erreur ? Ces questions soulignent l’importance de définir des mécanismes de responsabilité clairs et de garantir une supervision humaine appropriée dans le processus de prise de décision automatisée afin de prévenir des résultats indésirables et d’assurer un système éthique et équitable.

En parallèle, étant donné que l’intelligence artificielle repose également sur l’utilisation de données personnelles, il est essentiel de garantir leur sécurité et de limiter leur accès conformément aux diverses lois sur la protection des données individuelles. À cet égard, l’Europe se distingue des autres continents.

En effet, les réglementations sur la protection des données, telles que le Règlement général sur la protection des données (RGPD) de l’Union européenne, établissent des normes élevées en matière de protection des données personnelles (European Data Protection Board. (2021), Guidelines 1/2019 on Codes of Conduct and Monitoring Bodies under Regulation 2016/679).

Les gouvernements doivent donc veiller à la mise en œuvre et à l’application efficace de ces lois, afin d’assurer la confidentialité et la sécurité des données utilisées dans les systèmes d’intelligence artificielle.

Éthique et impact sur le marché du travail et sur la société en général

Une préoccupation éthique majeure liée à l’intelligence artificielle concerne son impact sur l’emploi. En effet, l’IA a déjà commencé à remplacer certains emplois, et cette tendance s’accélère, ce qui peut entraîner des répercussions négatives sur les personnes touchées par ces changements rapides.

Une récente étude menée par des chercheurs de l’Université de Pennsylvanie s’est penchée sur l’impact des modèles de langage basés sur l’apprentissage automatique (LLM) sur le marché du travail.

Les résultats ont révélé que 80% de la main-d’œuvre en Amérique du Nord verra au moins 10% de ses tâches quotidiennes affectées par l’introduction des GPT (Générateurs de Textes Prédictifs), et que 19% des employés verront au moins 50% de leurs tâches impactées.

Des professions aussi variées que les mathématiciens, les contrôleurs financiers, les auteurs, les écrivains et les interprètes sont directement exposées. Il n’y aura donc aucune distinction réelle entre les industries ou les niveaux de salaire, ce qui démontre que la perturbation en cours pourrait avoir d’importantes implications économiques, sociales et politiques. Une législation sera inévitable pour garantir que cette transition se déroule dans un cadre éthique et équitable.

Dans l’ensemble, les développements actuels de l’intelligence artificielle auront un impact profond sur la société, car ils s’intègrent dans tous les secteurs qui influencent directement notre vie quotidienne, tels que la santé, les transports, l’industrie, et bien d’autres encore. Cependant, ces avancées peuvent également être utilisées à des fins malveillantes, comme la surveillance de masse des individus ou le développement de robots autonomes. Il est donc essentiel que non seulement les programmeurs prennent conscience de l’importance d’utiliser ces nouvelles technologies de manière éthique, mais aussi que les gouvernements jouent un rôle prépondérant dans l’établissement de réglementations visant à protéger les libertés individuelles.

Il convient de souligner que l’intelligence artificielle ne peut en aucun cas remplacer les valeurs et l’éthique inhérentes à notre humanité, même si ses capacités de précision et d’exactitude la positionnent déjà pour surpasser les capacités humaines dans de nombreux domaines. Il est primordial que l’humanité reste consciente de l’impact potentiel d’un désengagement moral et éthique progressif résultant de l’automatisation complète des décisions, car cela pourrait entraîner des conséquences majeures. L’éthique et la responsabilité humaines doivent rester au cœur de l’utilisation de l’intelligence artificielle afin d’assurer un avenir bénéfique et équilibré pour tous.

En conclusion, l’intelligence artificielle et les technologies connexes qui la mettent en œuvre ont récemment franchi une étape importante et évoluent désormais de manière exponentielle. Bien que ces avancées offrent des avantages et des opportunités extraordinaires pour l’humanité, elles soulèvent également de nombreuses questions éthiques quant à leur utilisation. Afin de limiter les potentiels impacts négatifs sur la société, il est essentiel d’adopter une approche éthique globale dès la conception, l’implémentation et l’utilisation de ces technologies.

Il serait judicieux de généraliser des lois similaires au RGPD, qui sont actuellement en vigueur en Europe, afin de garantir la protection des données non personnelles lorsqu’elles sont utilisées comme source pour des algorithmes d’apprentissage. Cela permettrait d’éviter les biais et les boucles infinies de discrimination. De plus, il sera crucial de sensibiliser chaque individu sur la distinction entre une interaction avec un être humain ou une machine lorsque l’intelligence artificielle atteindra un niveau de compréhension équivalent au test de Turing, conçu pour évaluer la capacité d’une machine à exhiber un comportement intelligent indiscernable de celui d’un être humain (Turing, A. M., 1950).

À mesure que l’intelligence artificielle progresse à un rythme rapide, il devient impératif que la société tout entière se mobilise pour anticiper et réglementer son utilisation de manière éthique, afin de préserver les valeurs et les droits fondamentaux de chaque individu. En adoptant une approche responsable et réfléchie, nous pouvons exploiter au mieux ces technologies tout en minimisant les risques.

Dans un avenir proche, lorsque l’intelligence artificielle sera en mesure de passer avec succès le test de Turing, démontrant ainsi sa capacité conversationnelle, sa compréhension générale, sa conscience de soi, sa capacité d’apprentissage et d’adaptation, ainsi que d’autres traits associés à l’intelligence humaine, elle franchira un nouveau seuil et deviendra comparable à l’intelligence humaine.

À ce stade, il sera pratiquement impossible de faire la distinction entre une machine et un être humain. Cela soulève des questions fondamentales sur notre perception de l’intelligence et de l’identité, et nécessitera une réflexion approfondie sur la coexistence harmonieuse entre l’intelligence artificielle et l’humanité.

Bio express

Redda Ben Geloune est un leader charismatique et optimiste qui a consacré sa vie à faire de l’Afrique un endroit meilleur. Né en Côte d’Ivoire, il a obtenu son diplôme d’ingénieur à l’ENSICAEN en France, après avoir suivi des classes préparatoires scientifiques à Paris. Il est également diplômé de HEC Paris (eMBA) et alumni de la Harvard Business School (OPM50). En tant que fondateur du groupe Aitek (www.aitek.fr), l’une des principales sociétés de l’industrie informatique en Afrique, il a pour vision de créer un impact positif sur le continent en tirant parti de la convergence exponentielle des technologies.

Dans le domaine académique, Redda Ben Geloune a occupé le poste de co-directeur académique de Challenge + Afrique pendant deux années, un programme de HEC Paris visant à aider les entrepreneurs à construire des entreprises prospères. Parallèlement, en tant que doctorant (Phd) à la Case Western Reserve University aux États-Unis, il exerce comme chargé de recherche au Fowler Center for Business en tant qu’Agent of World Benefit.

Son objectif de recherche est de comprendre comment l’intelligence artificielle peut aider les organisations à former des équipes hautement performantes en capitalisant sur les facteurs psychologiques et cognitifs propres à chaque individu. En dehors de ses activités professionnelles, Redda Ben Geloune est passionné par les courses d’obstacles. Il est également fier d’être le père de deux filles, Wafa et Kahina.

Redda Ben Geloune